„Erwartungswert“ – Versionsunterschied

| [gesichtete Version] | [gesichtete Version] |

K →Allgemeine Definition: Bei der Zeichnung "mini" entfernt (weißer Hintergrund besser) und einen Tooltip ergänzt. |

|||

| (29 dazwischenliegende Versionen von 19 Benutzern werden nicht angezeigt) | |||

| Zeile 1: | Zeile 1: | ||

Der '''Erwartungswert''' (selten und doppeldeutig ''[[Mittelwert]]'') ist ein Grundbegriff der [[Stochastik]]. |

Der '''Erwartungswert''' (selten und doppeldeutig ''[[Mittelwert]]'') ist ein Grundbegriff der [[Stochastik]]. Der Erwartungswert ist eine Kennzahl einer [[Zufallsvariable]]n. Bei einer engeren Definition ist der Erwartungswert einer Zufallsvariablen eine reelle Zahl und damit endlich; bei einer weiteren Definition sind für den Erwartungswert einer Zufallsvariablen auch die Werte <math>\pm \infty</math> zugelassen. Es gibt Zufallsvariablen, für die kein Erwartungswert definiert ist. |

||

Hat eine Zufallsvariable einen endlichen Erwartungswert, so wird dieser häufig mit [[My|<math>\mu</math>]] abgekürzt; er beschreibt dann die Zahl, die die Zufallsvariable im Mittel annimmt. Er ergibt sich zum Beispiel bei unbegrenzter Wiederholung des zugrunde liegenden [[Wahrscheinlichkeitsexperiment|Experiments]] als Durchschnitt der Ergebnisse. Das [[Gesetz der großen Zahlen]] beschreibt, in welcher Form die Durchschnitte der Ergebnisse bei wachsender Anzahl der Experimente gegen den endlichen Erwartungswert streben, oder anders gesagt, wie die [[Stichprobenmittel]]werte bei wachsendem Stichprobenumfang gegen den Erwartungswert [[Konvergenz (Mathematik)|konvergieren]]. |

|||

| ⚫ | Ein endlicher Erwartungswert bestimmt die Lokalisation (Lage) der [[Wahrscheinlichkeitsverteilung|Verteilung]] der Zufallsvariablen und ist vergleichbar mit dem empirischen [[Arithmetisches Mittel|arithmetischen Mittel]] einer [[Häufigkeitsverteilung]] in der deskriptiven Statistik, jedoch mit einem wichtigen Unterschied: Der Erwartungswert ist der [[Wahrer Wert| |

||

| ⚫ | Ein endlicher Erwartungswert bestimmt die [[Lagemaß (Stochastik)|Lokalisation]] (Lage) der [[Wahrscheinlichkeitsverteilung|Verteilung]] der Zufallsvariablen und ist vergleichbar mit dem empirischen [[Arithmetisches Mittel|arithmetischen Mittel]] einer [[Häufigkeitsverteilung]] in der [[Deskriptive Statistik|deskriptiven Statistik]], jedoch mit einem wichtigen Unterschied: Der Erwartungswert ist der [[Wahrer Wert|„wahre“ Mittelwert]] einer [[Zufallsvariable]]n (Mittelwert der [[Grundgesamtheit]]), während sich das arithmetische Mittel in der Regel nur auf eine [[Stichprobe]] von Werten bezieht ([[Stichprobenmittel]]). Eine neue Stichprobe wird einen unterschiedlichen arithmetischen Mittelwert liefern, jedoch bleibt der Erwartungswert <math>\mu</math> immer gleich. {{Siehe auch|Lageparameter (deskriptive Statistik)}} |

||

| ⚫ | |||

| ⚫ | |||

Weil der Erwartungswert einer Zufallsvariablen nur von deren [[Wahrscheinlichkeitsverteilung]] abhängt, wird auch vom Erwartungswert einer Wahrscheinlichkeitsverteilung gesprochen, ohne Bezug auf eine Zufallsvariable. Der endliche Erwartungswert einer Zufallsvariablen kann als Schwerpunkt der Wahrscheinlichkeitsmasse betrachtet werden und wird daher als ihr [[Moment (Stochastik)|erstes Moment]] bezeichnet. |

Weil der Erwartungswert einer Zufallsvariablen nur von deren [[Wahrscheinlichkeitsverteilung]] abhängt, wird auch vom Erwartungswert einer Wahrscheinlichkeitsverteilung gesprochen, ohne Bezug auf eine Zufallsvariable. Der endliche Erwartungswert einer Zufallsvariablen kann als Schwerpunkt der Wahrscheinlichkeitsmasse betrachtet werden und wird daher als ihr [[Moment (Stochastik)|erstes Moment]] bezeichnet. |

||

| Zeile 17: | Zeile 18: | ||

Wie die Ergebnisse der Würfelwürfe ist der Mittelwert vom [[Zufall]] abhängig. Im Unterschied dazu ist der Erwartungswert eine feste Kennzahl der Verteilung der Zufallsvariablen <math>X</math>. |

Wie die Ergebnisse der Würfelwürfe ist der Mittelwert vom [[Zufall]] abhängig. Im Unterschied dazu ist der Erwartungswert eine feste Kennzahl der Verteilung der Zufallsvariablen <math>X</math>. |

||

Die Definition des Erwartungswerts steht in Analogie zum gewichteten Mittelwert von empirisch beobachteten Zahlen. Hat zum Beispiel eine Serie von zehn [[Spielwürfel|Würfelversuchen]] die Ergebnisse 4, |

Die Definition des Erwartungswerts steht in Analogie zum gewichteten Mittelwert von empirisch beobachteten Zahlen. Hat zum Beispiel eine Serie von zehn [[Spielwürfel|Würfelversuchen]] die Ergebnisse 4, 2, 1, 3, 6, 3, 3, 1, 4, 5 geliefert, kann der zugehörige Mittelwert |

||

:<math>\bar x=(4 + 2 + 1 + 3 + 6 + 3 + 3 + 1 + 4 + 5)\cdot\tfrac1{10} = 3{,}2</math> |

:<math>\bar x=(4 + 2 + 1 + 3 + 6 + 3 + 3 + 1 + 4 + 5)\cdot\tfrac1{10} = 3{,}2</math> |

||

alternativ berechnet werden, indem zunächst gleiche Werte zusammengefasst und nach ihrer [[Relative Häufigkeit|relativen Häufigkeit]] gewichtet werden: |

alternativ berechnet werden, indem zunächst gleiche Werte zusammengefasst und nach ihrer [[Relative Häufigkeit|relativen Häufigkeit]] gewichtet werden: |

||

:<math>\bar x = \tfrac 2{10}\cdot 1 + |

:<math>\bar x = \tfrac 2{10}\cdot 1 + \tfrac 1{10}\cdot 2 + \tfrac 3{10}\cdot 3 + \tfrac 2{10}\cdot 4 + \tfrac 1{10}\cdot 5 + \tfrac 1{10}\cdot 6 = 3{,}2</math>. |

||

Allgemein lässt der Mittelwert der Augenzahlen in <math>n</math> Würfen sich wie |

Allgemein lässt der Mittelwert der Augenzahlen in <math>n</math> Würfen sich wie |

||

| Zeile 29: | Zeile 30: | ||

== Begriff und Notation == |

== Begriff und Notation == |

||

=== Begriff=== |

=== Begriff === |

||

Das Konzept des Erwartungswertes geht auf [[Christiaan Huygens]] zurück. In einer Abhandlung über Glücksspiele von 1656 |

Das Konzept des Erwartungswertes geht auf [[Christiaan Huygens]] zurück. In einer Abhandlung über Glücksspiele von 1656 (''Van rekeningh in spelen van geluck'') beschreibt Huygens den erwarteten Gewinn eines Spiels als „het is my soo veel weerdt“ („es ist mir so viel wert“). [[Frans van Schooten]] verwendete in seiner Übersetzung von Huygens’ Text ins Lateinische den Begriff ''expectatio'' („Erwartung“). [[Jakob I Bernoulli|Bernoulli]] übernahm in seiner ''Ars conjectandi'' den von van Schooten eingeführten Begriff in der Form ''valor expectationis'' („Erwartungswert“).<ref>Norbert Henze: ''Stochastik für Einsteiger. Eine Einführung in die faszinierende Welt des Zufalls.'' 7., überarbeitete und erweiterte Auflage. Vieweg + Teubner, Wiesbaden 2008, ISBN 978-3-8348-0423-5, S. 79.</ref> |

||

=== Notation === |

=== Notation === |

||

Das Symbol E für ''Erwartungswert'' oder ''Expectation'' wurde in der englischsprachigen Literatur erst ab dem 20. Jahrhundert eingeführt.<ref>https://jeff560.tripod.com/stat.html</ref> |

Das Symbol E für ''Erwartungswert'' oder ''Expectation'' wurde in der englischsprachigen Literatur erst ab dem 20. Jahrhundert eingeführt.<ref name="Aldrich 2014">John Aldrich: ''Earliest Uses of Symbols in Probability and Statistics.'' 2014, ([https://jeff560.tripod.com/stat.html online]).</ref> |

||

Heute wird in der englischsprachigen und deutschsprachigen mathematischen Literatur häufig die Schreibweise <math>\operatorname{E}\left(X\right)</math> oder <math>\mathbb{E}\left(X\right)</math> oder auch mit eckigen Klammern <math>\operatorname{E}\left[X\right]</math> bzw. <math> \mathbb{E}\left[X\right]</math> für den Erwartungswert der Zufallsvariable <math>X</math> verwendet.<ref>Baden-Württembergische Lehrerinnen verwenden die Schreibweise <math>\operatorname{E}\left(X\right)</math> |

Heute wird in der englischsprachigen und deutschsprachigen mathematischen Literatur häufig die Schreibweise <math>\operatorname{E}\left(X\right)</math> oder <math>\mathbb{E}\left(X\right)</math> oder auch mit eckigen Klammern <math>\operatorname{E}\left[X\right]</math> bzw. <math> \mathbb{E}\left[X\right]</math> für den Erwartungswert der Zufallsvariable <math>X</math> verwendet.<ref> [https://lehrerfortbildung-bw.de/u_matnatech/mathematik/gym/bp2004/fb2/modul4/1_laengs/voraus/zufall/ Baden-Württembergische Lehrerinnen verwenden die Schreibweise <math>\operatorname{E}\left(X\right)</math>].</ref><ref>[[David Meintrup]], [[Stefan Schäffler]]: ''Stochastik. Theorie und Anwendungen.'' Springer, Berlin u. a. 2005, ISBN 3-540-21676-6.</ref> |

||

Gelegentlich werden auch |

Gelegentlich werden auch geschweifte Klammern verwendet.<ref>[[Eugen-Georg Woschni]]: ''Informationstechnik. Signal, System, Information.'' 2., bearbeitete Auflage. Verlag Technik, Berlin 1981.</ref> |

||

In der russischsprachigen Literatur findet sich die Bezeichnung <math>M(X)</math>.<ref>Siehe etwa (in deutscher Übersetzung) [[Albert Nikolajewitsch Schirjajew| |

In der russischsprachigen Literatur findet sich die Bezeichnung <math>M(X)</math>.<ref>Siehe etwa (in deutscher Übersetzung) [[Albert Nikolajewitsch Schirjajew|Albert N. Širjaev]]: ''Wahrscheinlichkeit'' (= ''[[Hochschulbücher für Mathematik]].'' 91). Deutscher Verlag der Wissenschaften, Berlin 1988, ISBN 3-326-00195-9, S. 52 ff.</ref> |

||

Gelegentlich werden auch die Klammern um die Zufallsvariable weggelassen, was der Schreibweise für [[Linearer Operator|Operatoren]] entspricht: <math>\operatorname{\it E}X</math> oder <math>\operatorname{\it M}X</math>.<ref>Siehe |

Gelegentlich werden auch die Klammern um die Zufallsvariable weggelassen, was der Schreibweise für [[Linearer Operator|Operatoren]] entspricht: <math>\operatorname{\it E}X</math> oder <math>\operatorname{\it M}X</math>.<ref>Siehe [[Ilja Nikolajewitsch Bronschtein|Ilja N. Bronstein]], [[Konstantin Adolfowitsch Semendjajew|Konstantin A. Semendjajew]]: ''[[Taschenbuch der Mathematik]].'' 23. Auflage. Deutsch, Thun u. a. 1987, ISBN 3-87144-492-8. Der Operator wird hier kursiv gesetzt.</ref> Mit der auch vorkommenden Notation <math>\mathbb{E}X</math> besteht hierbei nicht die Gefahr, dass der Operator <math>\mathbb{E}</math> mit einer Zufallsvariable verwechselt wird. Die Notation <math>\operatorname{E}\left[X\right]</math> mit den eckigen Klammern hebt speziell die Tatsache hervor, dass es sich hier um ein [[Funktional]] handelt. |

||

Die Bezeichnung <math>\mu_X</math> des Erwartungswerts der Zufallsvariable |

Die Bezeichnung <math>\mu_X</math> des Erwartungswerts der Zufallsvariable <math>X</math> betont die Eigenschaft als nicht vom Zufall abhängiges erstes Moment. In der Physik findet die [[Bra-Ket|Bra-Ket-Notation]] Verwendung.<ref name="Aldrich 2014" /> |

||

Insbesondere wird <math>\langle X \rangle</math> statt <math>\operatorname{E}(X)</math> für den Erwartungswert einer Größe <math>X</math> geschrieben. |

Insbesondere wird <math>\langle X \rangle</math> statt <math>\operatorname{E}(X)</math> für den Erwartungswert einer Größe <math>X</math> geschrieben. |

||

| Zeile 59: | Zeile 60: | ||

Ist <math>I = \mathbb{N}</math>, so besitzt <math>X</math> genau dann einen endlichen Erwartungswert <math>\operatorname{E}(X)</math>, wenn die [[Konvergenz in Wahrscheinlichkeit|Konvergenzbedingung]] |

Ist <math>I = \mathbb{N}</math>, so besitzt <math>X</math> genau dann einen endlichen Erwartungswert <math>\operatorname{E}(X)</math>, wenn die [[Konvergenz in Wahrscheinlichkeit|Konvergenzbedingung]] |

||

:<math>\lim_{a\rightarrow \infty}\sum_{i=1}^a |x_i|p_i = \sum_{i=1}^\infty |x_i|p_i <\infty</math> erfüllt ist, d. |

:<math>\lim_{a\rightarrow \infty}\sum_{i=1}^a |x_i|p_i = \sum_{i=1}^\infty |x_i|p_i <\infty</math> erfüllt ist, d. h. die Reihe für den Erwartungswert [[Absolute Konvergenz|absolut konvergent]] ist. |

||

Für nichtnegative ganzzahlige Zufallsvariablen ist oft die folgende Eigenschaft hilfreich<ref name="Ross"> |

Für nichtnegative ganzzahlige Zufallsvariablen ist oft die folgende Eigenschaft hilfreich<ref name="Ross">Sheldon M. Ross: ''Introduction to probability models.'' 9. Auflage. Academic Press, Amsterdam u. a. 2007, ISBN 978-0-12-598062-3, S. 143.</ref> |

||

:<math> \operatorname{E}(X)=\sum\limits_{i=1}^\infty P(X\geq i).</math> |

:<math> \operatorname{E}(X)=\sum\limits_{i=1}^\infty P(X\geq i).</math> |

||

| Zeile 68: | Zeile 69: | ||

=== Erwartungswert einer reellen Zufallsvariable mit Dichtefunktion === |

=== Erwartungswert einer reellen Zufallsvariable mit Dichtefunktion === |

||

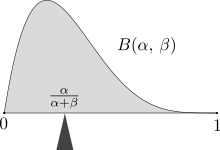

[[Datei:Beta first moment.svg|mini|Der Erwartungswert balanciert die Wahrscheinlichkeitsmasse – hier die Masse unter der Dichte einer Beta(α,β)-Verteilung mit Erwartungswert α/(α+β). Dies entspricht der Interpretation des Erwartungswertes als [[Massenmittelpunkt]].]] |

[[Datei:Beta first moment.svg|mini|Der Erwartungswert balanciert die Wahrscheinlichkeitsmasse – hier die Masse unter der Dichte einer Beta(α,β)-Verteilung mit Erwartungswert α/(α+β). Dies entspricht der Interpretation des Erwartungswertes als [[Massenmittelpunkt]].]] |

||

Hat eine reelle Zufallsvariable <math>X</math> eine [[Wahrscheinlichkeitsdichtefunktion]] <math>f</math>, das heißt hat das [[Bildmaß]] <math>P^X</math> |

Hat eine reelle Zufallsvariable <math>X</math> eine [[Wahrscheinlichkeitsdichtefunktion]] <math>f</math>, das heißt hat das [[Bildmaß]] <math>P^X</math> die [[Radon-Nikodym-Dichte|Dichte]] <math>f</math> bezüglich des [[Lebesgue-Maß]]es <math>\lambda</math>, so berechnet sich der Erwartungswert im Falle der Existenz als |

||

:(1) <math>\displaystyle\quad \operatorname E(X)= \int_{\mathbb{R}} x f(x)\,\mathrm{d}\lambda(x).</math> |

:(1) <math>\displaystyle\quad \operatorname E(X)= \int_{\mathbb{R}} x f(x)\,\mathrm{d}\lambda(x).</math> |

||

| Zeile 74: | Zeile 75: | ||

:(2) <math>\displaystyle\quad \operatorname E(X)=\int_{-\infty}^\infty x f(x)\,\mathrm{d}x.</math> |

:(2) <math>\displaystyle\quad \operatorname E(X)=\int_{-\infty}^\infty x f(x)\,\mathrm{d}x.</math> |

||

Gleichwertig zu dieser Gleichung ist, wenn <math>F</math> [[Verteilungsfunktion]] von |

Gleichwertig zu dieser Gleichung ist, wenn <math>F</math> [[Verteilungsfunktion]] von <math>X</math> ist: |

||

:(3) <math>\displaystyle\quad\operatorname E(X)=\int_0^\infty (1-F(x))\,\mathrm{d}x - \int_{-\infty}^0 F(x)\,\mathrm{d}x.</math> |

:(3){{Anker|(3)}} <math>\displaystyle\quad\operatorname E(X)=\int_0^\infty (1-F(x))\,\mathrm{d}x - \int_{-\infty}^0 F(x)\,\mathrm{d}x.</math> |

||

(2) und (3) sind unter der gemeinsamen Voraussetzung (<math>f</math> ist Dichtefunktion und <math>F</math> ist Verteilungsfunktion von <math>X</math>) äquivalent, was mit schulgemäßen Mitteln bewiesen werden kann.<ref> |

(2) und (3) sind unter der gemeinsamen Voraussetzung (<math>f</math> ist Dichtefunktion und <math>F</math> ist Verteilungsfunktion von <math>X</math>) äquivalent, was mit schulgemäßen Mitteln bewiesen werden kann.<ref>Helmut Wirths: ''Der Erwartungswert. Skizzen zur Begriffsentwicklung von Klasse 8 bis 13.'' In: ''Mathematik in der Schule.'' Band 33, Heft 6, 1995, S. 330–343.</ref> |

||

Für nichtnegative Zufallsvariablen folgt daraus die wichtige Beziehung zur [[Ereigniszeitanalyse#Überlebensfunktion|Zuverlässigkeitsfunktion]] <math>R(t)=1-F(t)</math> |

Für nichtnegative Zufallsvariablen folgt daraus die wichtige Beziehung zur [[Ereigniszeitanalyse#Überlebensfunktion|Zuverlässigkeitsfunktion]] <math>R(t)=1-F(t)</math> |

||

:<math> \operatorname{E}(X) = \int_0^\infty ( 1-F(t) ) \, \mathrm{d}t = \int_0^\infty R(t) |

:<math> \operatorname{E}(X) = \int_0^\infty ( 1-F(t) ) \, \mathrm{d}t = \int_0^\infty R(t) \, \mathrm{d}t.</math> |

||

=== Allgemeine Definition === |

=== Allgemeine Definition === |

||

Der Erwartungswert wird entsprechend als das [[Lebesgue-Integral]] bezüglich des [[Wahrscheinlichkeitsmaß]]es definiert: Ist <math>X</math> eine bezüglich dem Maß <math>P</math> integrierbare oder [[Quasiintegrierbarkeit|quasiintegrierbare]] Zufallsvariable auf einem [[Wahrscheinlichkeitsraum]] <math>(\Omega,\Sigma,P)</math> mit Werten in <math>(\overline{\R},\mathcal{B})</math>, wobei <math>\mathcal{B}</math> die [[Borelsche σ-Algebra]] über <math>\overline{\R}:=\R\cup\{-\infty,\infty\}</math> ist, so wird definiert |

Der Erwartungswert wird entsprechend als das [[Lebesgue-Integral]] bezüglich des [[Wahrscheinlichkeitsmaß]]es definiert: Ist <math>X</math> eine bezüglich dem Maß <math>P</math> integrierbare oder [[Quasiintegrierbarkeit|quasiintegrierbare]] Zufallsvariable auf einem [[Wahrscheinlichkeitsraum]] <math>(\Omega,\Sigma,P)</math> mit Werten in <math>(\overline{\R},\mathcal{B})</math>, wobei <math>\mathcal{B}</math> die [[Borelsche σ-Algebra]] über <math>\overline{\R}:=\R\cup\{-\infty,\infty\}</math> ist, so wird definiert |

||

:<math>\operatorname{E}(X) = \int_\Omega X \,\mathrm{d}P = \int_\Omega X(\omega)\mathrm{d}P(\omega)\,</math> |

:<math>\operatorname{E}(X) = \int_\Omega X \,\mathrm{d}P = \int_\Omega X(\omega)\,\mathrm{d}P(\omega)=\int_{\R} x\,P_X(\mathrm{d}x)</math> |

||

Die Zufallsvariable <math>X</math> besitzt genau dann einen Erwartungswert, wenn sie [[Quasiintegrierbarkeit|quasiintegrierbar]] ist, also die Integrale |

mit der [[Wahrscheinlichkeitsmaß#Wahrscheinlichkeitsverteilung einer Zufallsvariable|Wahrscheinlichkeitsverteilung]] <math>P_X=P\circ X^{-1}</math>. Die Zufallsvariable <math>X</math> besitzt genau dann einen Erwartungswert, wenn sie [[Quasiintegrierbarkeit|quasiintegrierbar]] ist, also die Integrale |

||

:<math>\int_\Omega X^+(\omega)\,\mathrm{d}P(\omega)</math> und <math>\int_\Omega X^-(\omega)\,\mathrm{d}P(\omega)</math> |

:<math>\int_\Omega X^+(\omega)\,\mathrm{d}P(\omega)</math> und <math>\int_\Omega X^-(\omega)\,\mathrm{d}P(\omega)</math> |

||

| Zeile 97: | Zeile 98: | ||

In diesem Fall schreiben viele Autoren, der Erwartungswert ''existiere'' oder <math>X</math> sei eine Zufallsvariable ''mit existierendem Erwartungswert'', und schließen damit den Fall <math>\infty</math> bzw. <math>-\infty</math> aus. |

In diesem Fall schreiben viele Autoren, der Erwartungswert ''existiere'' oder <math>X</math> sei eine Zufallsvariable ''mit existierendem Erwartungswert'', und schließen damit den Fall <math>\infty</math> bzw. <math>-\infty</math> aus. |

||

[[Datei:Roland Uhl 2023 Charakterisierung des Erwartungswertes Bild1.svg|hochkant=1.15|rahmenlos|rechts|rand|Erwartungswert µ und Median 𝑚]] |

|||

Der (endliche) Erwartungswert einer reellen Zufallsvariablen <math>X</math> kann aber auch am Graphen ihrer [[Verteilungsfunktion]] <math>F</math> durch eine naheliegende Flächengleichheit festgelegt werden. Es ist nämlich <math>\operatorname{E}(X) = \mu</math> mit einer reellen Zahl <math>\mu</math> genau dann, wenn in der <math>x</math>-<math>y</math>-Ebene die beiden Flächen, beschrieben durch |

|||

:<math> |

|||

x\le\mu,\;\, 0\le y\le F(x) \quad</math> bzw. <math>\quad x\ge\mu,\;\, F(x)\le y\le 1, |

|||

</math> |

|||

denselben endlichen Flächeninhalt haben, d. h. wenn |

|||

:<math> |

|||

\int_{-\infty}^\mu F(x)\,\mathrm{d}x = \int_\mu^\infty \big(1 - F(x)\big)\,\mathrm{d}x |

|||

</math> |

|||

gilt und beide [[Uneigentliches Integral|uneigentlichen Riemann-Integrale]] konvergieren. Dazu äquivalent ist die allgemeingültige Darstellung [[Erwartungswert#(3)|(3)]], ebenfalls mit konvergenten Integralen.<ref>Roland Uhl: ''Charakterisierung des Erwartungswertes am Graphen der Verteilungsfunktion''. Technische Hochschule Brandenburg, 2023, {{DOI|10.25933/opus4-2986}} ([https://opus4.kobv.de/opus4-fhbrb/files/2986/Uhl2023.pdf PDF]). S. 2–4.</ref> |

|||

== Elementare Eigenschaften == |

== Elementare Eigenschaften == |

||

| Zeile 110: | Zeile 122: | ||

:<math>\operatorname{E}\left(\sum_{i=1}^nX_i\right)=\sum_{i=1}^n\operatorname{E}(X_i)</math> |

:<math>\operatorname{E}\left(\sum_{i=1}^nX_i\right)=\sum_{i=1}^n\operatorname{E}(X_i)</math> |

||

Die Linearität des Erwartungswertes für Zufallsvariablen mit endlichem Erwartungswert folgt aus der [[Lebesgue-Integral#Wichtige Eigenschaften des Lebesgue-Integrals|Linearität des Integrals]] für integrierbare Funktionen. |

Die Linearität des Erwartungswertes für Zufallsvariablen mit endlichem Erwartungswert folgt aus der [[Lebesgue-Integral#Wichtige Eigenschaften des Lebesgue-Integrals|Linearität des Integrals]] für integrierbare Funktionen. |

||

Die Voraussetzung endlicher Erwartungswerte ist wesentlich für die Anwendung der Linearitätseigenschaft als Rechenregel. Beispielsweise ist es möglich, dass <math> \operatorname{E}(X_1)= -\infty</math> und <math> \operatorname{E}(X_2)= +\infty</math> und |

Die Voraussetzung endlicher Erwartungswerte ist wesentlich für die Anwendung der Linearitätseigenschaft als Rechenregel. Beispielsweise ist es möglich, dass <math> \operatorname{E}(X_1)= -\infty</math> und <math> \operatorname{E}(X_2)= +\infty</math> und der Erwartungswert von <math>X_1 + X_2</math> nicht definiert ist oder in anderen Fällen endlich ist. |

||

=== Monotonie === |

=== Monotonie === |

||

Existieren die Erwartungswerte <math> \operatorname{E}(X)</math> und <math>\operatorname{E}(Y)</math>, so gilt |

Existieren die Erwartungswerte <math> \operatorname{E}(X)</math> und <math>\operatorname{E}(Y)</math>, so gilt |

||

:<math> X \leq Y \implies \operatorname{E}(X) \leq \operatorname{E}(Y) </math>. |

:<math> X \leq Y \implies \operatorname{E}(X) \leq \operatorname{E}(Y) </math>. |

||

Die Voraussetzung <math> X \leq Y</math>, d. |

Die Voraussetzung <math> X \leq Y</math>, d. h. <math> X(\omega) \leq Y(\omega)</math> für alle <math> \omega \in \Omega</math>, lässt sich abschwächen zu <math> P(X \leq Y) = 1</math>, d. h. <math> X \leq Y</math> [[fast sicher]]. |

||

=== Wahrscheinlichkeiten als Erwartungswerte === |

=== Wahrscheinlichkeiten als Erwartungswerte === |

||

| Zeile 131: | Zeile 143: | ||

und |

und |

||

:<math> \operatorname E (|X+Y|) \leq \operatorname E (|X|)+\operatorname E (|Y|) </math> |

:<math> \operatorname E (|X+Y|) \leq \operatorname E (|X|)+\operatorname E (|Y|) </math>. |

||

== Beispiele == |

== Beispiele == |

||

| Zeile 143: | Zeile 155: | ||

=== Sankt-Petersburg-Paradoxon === |

=== Sankt-Petersburg-Paradoxon === |

||

Das [[Sankt-Petersburg-Paradoxon]] beschreibt ein Glücksspiel, dessen zufälliger Gewinn <math>X</math> einen unendlichen Erwartungswert hat. Gemäß der klassischen Entscheidungstheorie, die auf der Erwartungswertregel <math>X \succcurlyeq Y \Leftrightarrow \operatorname{E}(X) \geq \operatorname{E}(Y)</math> basiert, sollte man daher einen beliebig hohen Einsatz riskieren. Da die Wahrscheinlichkeit für einen Verlust des Einsatzes aber <math>50%</math> beträgt, erscheint diese Empfehlung nicht rational. Eine Lösung des Paradoxons stellt die Verwendung einer logarithmischen [[Nutzenfunktion (Mikroökonomie)|Nutzenfunktion]] dar. |

Das [[Sankt-Petersburg-Paradoxon]] beschreibt ein Glücksspiel, dessen zufälliger Gewinn <math>X</math> einen unendlichen Erwartungswert hat. Gemäß der klassischen Entscheidungstheorie, die auf der [[Entscheidung unter Risiko#Die Bayes-Regel|Erwartungswertregel]] <math>X \succcurlyeq Y \Leftrightarrow \operatorname{E}(X) \geq \operatorname{E}(Y)</math> basiert, sollte man daher einen beliebig hohen Einsatz riskieren. Da die Wahrscheinlichkeit für einen Verlust des Einsatzes aber <math>50%</math> beträgt, erscheint diese Empfehlung nicht rational. Eine Lösung des Paradoxons stellt die Verwendung einer logarithmischen [[Nutzenfunktion (Mikroökonomie)|Nutzenfunktion]] dar. |

||

=== Zufallsvariable mit Dichte === |

=== Zufallsvariable mit Dichte === |

||

Gegeben ist die reelle Zufallsvariable <math>X</math> mit der Dichtefunktion |

Gegeben ist die reelle Zufallsvariable <math>X</math> mit der Dichtefunktion |

||

:<math>f(x) = \begin{cases} |

:<math>f(x) = \begin{cases} \frac 1x, & 3 \le x \le 3\mathrm{e}, \\ |

||

& \\ |

& \\ |

||

0, & \text {sonst} \end{cases} </math> |

0, & \text {sonst} \end{cases} </math> |

||

| Zeile 156: | Zeile 168: | ||

:<math>\begin{align} |

:<math>\begin{align} |

||

\operatorname E(X)&= \int_{-\infty}^\infty x f(x)\,\mathrm{d}x = \int_{-\infty}^3 x \cdot 0\,\mathrm{d}x + \int_3^{3\mathrm{e}} x \cdot \frac 1x\,\mathrm{d}x + \int_{3\mathrm{e}}^\infty x \cdot 0 \,\mathrm{d}x\\ |

|||

&= 0 + \int_3^{3\mathrm{e}} 1\,\mathrm{d}x + 0 = [x]^{3\mathrm{e}}_3 = 3\mathrm{e}-3 = 3(\mathrm{e}-1). |

|||

\end{align}</math> |

\end{align}</math> |

||

| Zeile 202: | Zeile 214: | ||

:<math> \operatorname{E}\!\left(X_iX_j\right) = \operatorname{E}\!\left(X_i\right) \cdot \operatorname{E}\!\left(X_j\right)</math> für <math>i \neq j</math>. |

:<math> \operatorname{E}\!\left(X_iX_j\right) = \operatorname{E}\!\left(X_i\right) \cdot \operatorname{E}\!\left(X_j\right)</math> für <math>i \neq j</math>. |

||

Wenn die Zufallsvariablen <math>X_1,\dots,X_n</math> stochastisch unabhängig sind und die Zufallsvariablen <math>g_1(X_1),\dots, g_n(X_n)</math> endliche Erwartungswerte besitzen, dann hat auch das Produkt <math>\prod_{i=1}^n g_i(X_i)</math> einen endlichen Erwartungswert und es gilt |

Wenn die Zufallsvariablen <math>X_1,\dots,X_n</math> stochastisch unabhängig sind und die Zufallsvariablen <math>g_1(X_1),\dots, g_n(X_n)</math> endliche Erwartungswerte besitzen, dann hat auch das Produkt <math>\prod_{i=1}^n g_i(X_i)</math> einen endlichen Erwartungswert und es gilt |

||

:<math>\operatorname{E}\!\left(\prod_{i=1}^n g_i(X_i) \right) = \prod_{i=1}^n \operatorname{E}( |

:<math>\operatorname{E}\!\left(\prod_{i=1}^n g_i(X_i) \right) = \prod_{i=1}^n \operatorname{E}(g_i(X_i))</math>.<ref>{{Literatur |Autor=Galen R. Shorack | Titel=Probability for Statisticians |Reihe=Springer Texts in Statistics |Auflage=2 |Verlag=Springer |Ort=Cham |Datum=2017 |ISBN=978-3-319-52206-7 |DOI=10.1007/978-3-319-52207-4 |Seiten=128 |Fundstelle= Theorem 1.1}}</ref> |

||

Die Voraussetzung endlicher Erwartungswerte ist wesentlich. Wenn beispielsweise zwei stochastisch unabhängige Zufallsvariablen <math>X_1</math> und <math>X_2</math> die Erwartungswerte <math>\operatorname{E}(X_1) \in \R</math> und <math>\operatorname{E}(X_2) = +\infty</math> haben, dann ist es möglich, dass <math>\operatorname{E}(X_1X_2)</math> nicht definiert ist. Die Zufallsvariable <math>Y</math> besitze eine [[Cauchy-Verteilung|Standard-Cauchy-Verteilung]], dann ist <math>\operatorname{E}(Y)</math> nicht definiert. Andererseits gilt <math>Y =X_1X_2</math> mit <math>X_1 := \mathrm{sign}(Y)</math>, <math>X_2 := |Y|</math>, wobei <math>X_1</math> und <math>X_2</math> stochastisch unabhängig sind mit den Erwartungswerten <math>\operatorname{E}(X_1) =0</math> und <math>\operatorname{E}(X_2) = +\infty</math>. |

Die Voraussetzung endlicher Erwartungswerte ist wesentlich. Wenn beispielsweise zwei stochastisch unabhängige Zufallsvariablen <math>X_1</math> und <math>X_2</math> die Erwartungswerte <math>\operatorname{E}(X_1) \in \R</math> und <math>\operatorname{E}(X_2) = +\infty</math> haben, dann ist es möglich, dass <math>\operatorname{E}(X_1X_2)</math> nicht definiert ist. Die Zufallsvariable <math>Y</math> besitze eine [[Cauchy-Verteilung|Standard-Cauchy-Verteilung]], dann ist <math>\operatorname{E}(Y)</math> nicht definiert. Andererseits gilt <math>Y =X_1X_2</math> mit <math>X_1 := \mathrm{sign}(Y)</math>, <math>X_2 := |Y|</math>, wobei <math>X_1</math> und <math>X_2</math> stochastisch unabhängig sind mit den Erwartungswerten <math>\operatorname{E}(X_1) =0</math> und <math>\operatorname{E}(X_2) = +\infty</math>. |

||

| Zeile 210: | Zeile 222: | ||

:<math>\operatorname{E}\!\left(XY\right) =\operatorname{E}\!\left(X\right)\operatorname{E}\!\left(Y\right)+\operatorname{Cov}\!\left(X,Y\right)</math> |

:<math>\operatorname{E}\!\left(XY\right) =\operatorname{E}\!\left(X\right)\operatorname{E}\!\left(Y\right)+\operatorname{Cov}\!\left(X,Y\right)</math> |

||

Dabei ist <math>\operatorname{Cov}\!\left(X,Y\right)</math> die [[Kovarianz (Stochastik)|Kovarianz]] zwischen |

Dabei ist <math>\operatorname{Cov}\!\left(X,Y\right)</math> die [[Kovarianz (Stochastik)|Kovarianz]] zwischen <math>X</math> und <math>Y</math>. |

||

=== Erwartungswert einer zusammengesetzten Zufallsvariable === |

=== Erwartungswert einer zusammengesetzten Zufallsvariable === |

||

| Zeile 253: | Zeile 265: | ||

:<math>m_X(t):=\operatorname{E}\left(t^X\right)</math>. |

:<math>m_X(t):=\operatorname{E}\left(t^X\right)</math>. |

||

berechnen. Es gilt dann |

berechnen. Es gilt dann |

||

:<math>\operatorname{E}\left[X \right] = |

:<math>\operatorname{E}\left[X \right] = \lim_{t \uparrow 1} m_X'(t)</math>, |

||

falls der [[Grenzwert (Funktion)#Einseitige Grenzwerte|linksseitige Grenzwert]] existiert. |

falls der [[Grenzwert (Funktion)#Einseitige Grenzwerte|linksseitige Grenzwert]] existiert. |

||

=== Beste Approximation === |

=== Beste Approximation === |

||

Ist <math> X </math> eine Zufallsgröße auf einem [[Wahrscheinlichkeitsraum]] <math>(\Omega,\Sigma,P)</math>, so beschreibt <math> \operatorname{E} \left( X \right)</math> die beste Approximation an <math> X </math> im Sinne der Minimierung von <math> \operatorname{E} \left( |

Ist <math> X </math> eine Zufallsgröße auf einem [[Wahrscheinlichkeitsraum]] <math>(\Omega,\Sigma,P)</math>, so beschreibt <math> \operatorname{E} \left( X \right)</math> die beste Approximation an <math> X </math> im Sinne der Minimierung von <math> \operatorname{E} \left( \left( X-a \right)^2 \right) </math>, wobei ''a'' eine reelle Konstante ist. Dies folgt aus dem Satz über die beste Approximation, da |

||

:<math> \langle X-\operatorname{E}(X), b \rangle =0 </math> |

:<math> \langle X-\operatorname{E}(X), b \rangle =0 </math> |

||

für alle konstanten <math> b </math> ist, wobei <math> \langle .,. \rangle </math> das [[Lp-Raum#Der Hilbertraum L2|<math> L^2 </math>-Standardnormalskalarprodukt]] bezeichne. Diese Auffassung des Erwartungswertes macht die Definition der [[Varianz (Stochastik)|Varianz]] als minimaler [[Varianz (Stochastik)#Interpretation als Abstand|mittlerer quadratischer Abstand]] sinnvoll, siehe auch [[Fréchet-Prinzip]]. |

für alle konstanten <math> b </math> ist, wobei <math> \langle .,. \rangle </math> das [[Lp-Raum#Der Hilbertraum L2|<math> L^2 </math>-Standardnormalskalarprodukt]] bezeichne. Diese Auffassung des Erwartungswertes macht die Definition der [[Varianz (Stochastik)|Varianz]] als minimaler [[Varianz (Stochastik)#Interpretation als Abstand|mittlerer quadratischer Abstand]] sinnvoll, siehe auch [[Fréchet-Prinzip]]. |

||

| Zeile 272: | Zeile 284: | ||

Bei einer diskreten Zufallsvariablen <math>X</math> mit der Wahrscheinlichkeitsfunktion <math>p_X</math> wird die Summe |

Bei einer diskreten Zufallsvariablen <math>X</math> mit der Wahrscheinlichkeitsfunktion <math>p_X</math> wird die Summe |

||

:<math>\operatorname{E}(g(X))=\sum_i g(x_i) |

:<math>\operatorname{E}(g(X))=\sum_i g(x_i) p_X(x_i)</math> |

||

verwendet. Enthält die Summe unendlich viele Summanden, dann muss die Reihe [[Absolute Konvergenz|absolut konvergieren]], damit der Erwartungswert endlich ist. |

verwendet. Enthält die Summe unendlich viele Summanden, dann muss die Reihe [[Absolute Konvergenz|absolut konvergieren]], damit der Erwartungswert endlich ist. |

||

Im allgemeinen Fall einer Zufallsvariablen <math>X</math> mit der Verteilungsfunktion <math>F_X</math> kann der Erwartungswert mit Hilfe des Lebesgue-Stieltjes-Integral als |

Im allgemeinen Fall einer Zufallsvariablen <math>X</math> mit der Verteilungsfunktion <math>F_X</math> kann der Erwartungswert mit Hilfe des Lebesgue-Stieltjes-Integral als |

||

:<math>\operatorname{E}(g(X))=\int_{-\infty}^\infty g(x)\mathrm{d}F_X(x)</math> |

:<math>\operatorname{E}(g(X))=\int_{-\infty}^\infty g(x)\mathrm{d}F_X(x)</math> |

||

bestimmt werden. <math>\operatorname{E}(g(X))</math> ist endlich, falls <math>\operatorname{E}(|g(X)|)</math> endlich ist. Falls mindestens einer der nichtnegativen Erwartungswerte <math>\operatorname{E}((g(X))^+) = \operatorname{E}(\max(0,g(X)) </math> und <math>\operatorname{E}((g(X))^-) = \operatorname{E}(\max(0,-g(X))</math> endlich ist, ist <math>\operatorname{E}(g(X))</math> = <math>\operatorname{E}((g(X))^+) - \operatorname{E}((g(X))^-) \in \bar \R</math>, anderenfalls ist <math>\operatorname{E}(g(X))</math> nicht definiert. Falls nicht nur endliche Erwartungswerte interessieren, müssen analoge Fallunterscheidungen auch für die Fälle einer stetigen oder diskreten Zufallsvariable vorgenommen werden, d. |

bestimmt werden. <math>\operatorname{E}(g(X))</math> ist endlich, falls <math>\operatorname{E}(|g(X)|)</math> endlich ist. Falls mindestens einer der nichtnegativen Erwartungswerte <math>\operatorname{E}((g(X))^+) = \operatorname{E}(\max(0,g(X)) </math> und <math>\operatorname{E}((g(X))^-) = \operatorname{E}(\max(0,-g(X))</math> endlich ist, ist <math>\operatorname{E}(g(X))</math> = <math>\operatorname{E}((g(X))^+) - \operatorname{E}((g(X))^-) \in \bar \R</math>, anderenfalls ist <math>\operatorname{E}(g(X))</math> nicht definiert. Falls nicht nur endliche Erwartungswerte interessieren, müssen analoge Fallunterscheidungen auch für die Fälle einer stetigen oder diskreten Zufallsvariable vorgenommen werden, d. h. die positiven und die negativen Werte von <math>g(x)</math> müssen getrennt ausgewertet werden. |

||

=== Funktion von zwei Zufallsvariablen mit gemeinsamer Dichtefunktion === |

=== Funktion von zwei Zufallsvariablen mit gemeinsamer Dichtefunktion === |

||

| Zeile 302: | Zeile 314: | ||

{{Hauptartikel|Lagemaß (Stochastik)}} |

{{Hauptartikel|Lagemaß (Stochastik)}} |

||

Wird der Erwartungswert als Schwerpunkt der Verteilung einer Zufallsvariable aufgefasst, so handelt es sich um einen Lageparameter. Dieser gibt an, wo sich der Hauptteil der Verteilung befindet. Weitere Lageparameter sind |

Wird der Erwartungswert als Schwerpunkt der Verteilung einer Zufallsvariable aufgefasst, so handelt es sich um einen Lageparameter. Dieser gibt an, wo sich der Hauptteil der Verteilung befindet. Weitere Lageparameter sind |

||

# [[Modus (Stochastik)| |

# der [[Modus (Stochastik)|Modus]]: Der Modus gibt an, an welcher Stelle die Verteilung ein Maximum hat, sprich bei diskreten Zufallsvariablen die Ausprägung mit der größten Wahrscheinlichkeit und bei stetigen Zufallsvariable die Maximastellen der Dichtefunktion. Der Modus existiert zwar im Gegensatz zum Erwartungswert immer, muss aber nicht eindeutig sein. Beispiele für nichteindeutige Modi sind [[bimodale Verteilung]]en. |

||

# |

# der [[Median (Stochastik)|Median]] ist ein weiterer gebräuchlicher Lageparameter. Er gibt an, welcher Wert auf der x-Achse die Wahrscheinlichkeitsdichte so trennt, dass links und rechts des Medians jeweils die Hälfte der Wahrscheinlichkeit anzutreffen ist. Auch der Median existiert immer, muss aber (je nach Definition) nicht eindeutig sein. |

||

=== Momente === |

=== Momente === |

||

| Zeile 322: | Zeile 334: | ||

der quantenmechanische ''Erwartungswert'' von <math>\hat O</math> im Zustand <math>|\psi(t)\rangle</math>. |

der quantenmechanische ''Erwartungswert'' von <math>\hat O</math> im Zustand <math>|\psi(t)\rangle</math>. |

||

<math>M</math> ist hierbei der Ortsraum, in dem sich das Teilchen bewegt, <math>n</math> ist die Dimension von <math>M</math>, und ein hochgestellter Stern steht für [[Komplexe Zahl|komplexe]] [[ |

<math>M</math> ist hierbei der Ortsraum, in dem sich das Teilchen bewegt, <math>n</math> ist die Dimension von <math>M</math>, und ein hochgestellter Stern steht für [[Komplexe Zahl|komplexe]] [[Komplexe Konjugation|Konjugation]]. |

||

Lässt sich <math>\hat O</math> als formale [[Potenzreihe]] <math>O(\hat r,\hat p)</math> schreiben (und das ist oft so), so wird die Formel verwendet |

Lässt sich <math>\hat O</math> als formale [[Potenzreihe]] <math>O(\hat r,\hat p)</math> schreiben (und das ist oft so), so wird die Formel verwendet |

||

:<math>\langle \hat O\rangle_\psi = \int_M \mathrm{d}^n r\, \psi^\star(r,t) O(r,\frac{\hbar}{i}\nabla_r)\psi(r,t).</math> |

:<math>\langle \hat O\rangle_\psi = \int_M \mathrm{d}^n r\, \psi^\star(r,t) O\left(r,\frac{\hbar}{i}\nabla_r\right)\psi(r,t).</math> |

||

Der Index an der Erwartungswertsklammer wird nicht nur wie hier abgekürzt, sondern manchmal auch ganz weggelassen. |

Der Index an der Erwartungswertsklammer wird nicht nur wie hier abgekürzt, sondern manchmal auch ganz weggelassen. |

||

| Zeile 367: | Zeile 379: | ||

</math>. |

</math>. |

||

Falls ein <math>n \times 1</math>-[[Zufallsvektor]] <math>\mathbf{X}</math> vorliegt gilt: |

Falls ein <math>n \times 1</math>-[[Zufallsvektor]] <math>\mathbf{X}</math> vorliegt, gilt: |

||

<math>\operatorname{E}(\mathbf{X}) = \operatorname{E}\begin{pmatrix} |

: <math>\operatorname{E}(\mathbf{X}) = \operatorname{E}\begin{pmatrix} |

||

X_1 \\ |

X_1 \\ |

||

X_2 \\ |

X_2 \\ |

||

| Zeile 392: | Zeile 404: | ||

== Literatur == |

== Literatur == |

||

* {{Literatur |Autor=[[Krishna B. Athreya]], [[Soumendra N. Lahiri]] |Titel=Measure Theory and Probability Theory |Reihe=Springer Texts in Statistics |Verlag= |

* {{Literatur |Autor=[[Krishna B. Athreya]], [[Soumendra N. Lahiri]] |Titel=Measure Theory and Probability Theory |Reihe=Springer Texts in Statistics |Verlag=Springer |Ort=New York NY u. a. |Datum=2006 |ISBN=0-387-32903-X |Online=[http://ams.math.uni-bielefeld.de/mathscinet/search/publdoc.html?arg3=&co4=AND&co5=AND&co6=AND&co7=AND&dr=all&pg4=AUCN&pg5=TI&pg6=TI&pg7=ALLF&pg8=ET&r=1&review_format=html&s4=Athreya&s5=probability%20theory&s6=&s7=&s8=All&vfpref=html&yearRangeFirst=&yearRangeSecond=&yrop=eq MR2247694]}} |

||

* {{Literatur |Autor=[[Heinz Bauer (Mathematiker)|Heinz Bauer]] |Titel=Wahrscheinlichkeitstheorie |Reihe=De Gruyter Lehrbuch |Auflage=5., durchgesehene und verbesserte |Verlag= |

* {{Literatur |Autor=[[Heinz Bauer (Mathematiker)|Heinz Bauer]] |Titel=Wahrscheinlichkeitstheorie |Reihe=De Gruyter Lehrbuch |Auflage=5., durchgesehene und verbesserte |Verlag=de Gruyter |Ort=Berlin u. a. |Datum=2002 |ISBN=3-11-017236-4 |Online=[http://ams.math.uni-bielefeld.de/mathscinet/search/publdoc.html?arg3=&co4=AND&co5=AND&co6=AND&co7=AND&dr=all&pg4=AUCN&pg5=TI&pg6=PC&pg7=ALLF&pg8=ET&review_format=html&s4=Bauer%2C%20Heinz&s5=%09Wahrscheinlichkeitstheorie&s6=&s7=&s8=All&vfpref=html&yearRangeFirst=&yearRangeSecond=&yrop=eq&r=1&mx-pid=1902050 MR1902050]}} |

||

* {{Literatur |Autor=[[Kai Lai Chung]] |Titel=A Course in Probability Theory | |

* {{Literatur |Autor=[[Kai Lai Chung]] |Titel=A Course in Probability Theory |Auflage=3. |Verlag=Academic Press |Ort=San Diego CA u. a. |Datum=2001 |ISBN=0-12-174151-6 |Online=[http://ams.math.uni-bielefeld.de/mathscinet/search/publdoc.html?arg3=&co4=AND&co5=AND&co6=AND&co7=AND&dr=all&pg4=AUCN&pg5=TI&pg6=PC&pg7=ALLF&pg8=ET&review_format=html&s4=Chung&s5=Course&s6=&s7=&s8=All&vfpref=html&yearRangeFirst=&yearRangeSecond=&yrop=eq&r=2&mx-pid=1796326 R1796326]}} |

||

* {{Literatur |Autor=[[Walter Greiner]] |Titel=Quantenmechanik |Auflage=6. |

* {{Literatur |Autor=[[Walter Greiner]] |Titel=Quantenmechanik |Auflage=6. überarbeitete und erweiterte |Verlag=Deutsch |Ort=Frankfurt am Main |Datum=2005 |ISBN=3-8171-1765-5}} |

||

* {{Literatur |Autor=[[Erich Härtter]] |Titel=Wahrscheinlichkeitsrechnung für Wirtschafts- und Naturwissenschaftler | |

* {{Literatur |Autor=[[Erich Härtter]] |Titel=Wahrscheinlichkeitsrechnung für Wirtschafts- und Naturwissenschaftler |Reihe=[[Uni-Taschenbücher]] |NummerReihe=409 | Verlag=Vandenhoeck & Ruprecht |Ort=Göttingen |Datum=1974 |ISBN=3-525-03114-9}} |

||

* {{Literatur |Autor=[[Norbert Henze]] |Titel=Stochastik für Einsteiger |Auflage=10. |Verlag= |

* {{Literatur |Autor=[[Norbert Henze]] |Titel=Stochastik für Einsteiger. Eine Einführung in die faszinierende Welt des Zufalls |Auflage=10., überarbeitete |Verlag=Springer Spektrum |Ort=Wiesbaden |Datum=2013 |ISBN=978-3-658-03076-6}} |

||

* {{Literatur |Autor=[[Achim Klenke]] |Titel=Wahrscheinlichkeitstheorie |Auflage=3., überarbeitete und ergänzte |Verlag= |

* {{Literatur |Autor=[[Achim Klenke]] |Titel=Wahrscheinlichkeitstheorie |Auflage=3., überarbeitete und ergänzte |Verlag=Springer Spektrum |Ort=Berlin u. a. |Datum=2013 |ISBN=978-3-642-36017-6}} |

||

* {{Literatur |Autor=[[Norbert Kusolitsch]] |Titel=Maß- und Wahrscheinlichkeitstheorie |

* {{Literatur |Autor=[[Norbert Kusolitsch]] |Titel=Maß- und Wahrscheinlichkeitstheorie. Eine Einführung |Reihe=Springer-Lehrbuch |Auflage=2., überarbeitete und erweiterte |Verlag=Springer Spektrum |Ort=Heidelberg u. a. |Datum=2014 |ISBN=978-3-642-45386-1}} |

||

* {{Literatur |Autor=[[Michel |

* {{Literatur |Autor=[[Michel Loève]] |Titel=Probability Theory I |Reihe=[[Graduate Texts in Mathematics]] |BandReihe=45 |Auflage=4. |Verlag=Springer Verlag |Ort=New York NY u. a. |Datum=1977 |ISBN=3-540-90210-4 |Online=[http://ams.math.uni-bielefeld.de/mathscinet/search/publdoc.html?arg3=&co4=AND&co5=AND&co6=AND&co7=AND&dr=all&pg4=AUCN&pg5=TI&pg6=PC&pg7=ALLF&pg8=ET&review_format=html&s4=Loeve&s5=Probability%20Theory&s6=&s7=&s8=All&vfpref=html&yearRangeFirst=&yearRangeSecond=&yrop=eq&r=2&mx-pid=651017 MR0651017]}} |

||

* {{Literatur |Autor=[[Vladimir Spokoiny]], [[Thorsten Dickhaus]] |Titel=Basics of Modern Mathematical Statistics |Reihe=Springer Texts in Statistics |Verlag=Springer |

* {{Literatur |Autor=[[Vladimir Spokoiny]], [[Thorsten Dickhaus]] |Titel=Basics of Modern Mathematical Statistics |Reihe=Springer Texts in Statistics |Verlag=Springer |Ort=Heidelberg u. a. |Datum=2015 |ISBN=978-3-642-39908-4 |Online=[http://ams.math.uni-bielefeld.de/mathscinet/search/publdoc.html?arg3=&co4=AND&co5=AND&co6=AND&co7=AND&dr=all&pg4=AUCN&pg5=TI&pg6=PC&pg7=ALLF&pg8=ET&review_format=html&s4=Spokoiny&s5=Basics&s6=&s7=&s8=All&vfpref=html&yearRangeFirst=&yearRangeSecond=&yrop=eq&r=1&mx-pid=3289985 MR3289985]}} |

||

== Weblinks == |

|||

* [http://visual-math.de/stochastik/erwartungswert.html Interaktive Visualisierung von Würfelbeispiel] |

|||

== Einzelnachweise == |

== Einzelnachweise == |

||

| Zeile 411: | Zeile 420: | ||

{{Normdaten|TYP=s|GND=4152930-3}} |

{{Normdaten|TYP=s|GND=4152930-3}} |

||

[[Kategorie:Zufallsvariable]] |

|||

[[Kategorie:Stochastik]] |

[[Kategorie:Stochastik]] |

||

Aktuelle Version vom 2. Juni 2024, 16:32 Uhr

Der Erwartungswert (selten und doppeldeutig Mittelwert) ist ein Grundbegriff der Stochastik. Der Erwartungswert ist eine Kennzahl einer Zufallsvariablen. Bei einer engeren Definition ist der Erwartungswert einer Zufallsvariablen eine reelle Zahl und damit endlich; bei einer weiteren Definition sind für den Erwartungswert einer Zufallsvariablen auch die Werte zugelassen. Es gibt Zufallsvariablen, für die kein Erwartungswert definiert ist.

Hat eine Zufallsvariable einen endlichen Erwartungswert, so wird dieser häufig mit abgekürzt; er beschreibt dann die Zahl, die die Zufallsvariable im Mittel annimmt. Er ergibt sich zum Beispiel bei unbegrenzter Wiederholung des zugrunde liegenden Experiments als Durchschnitt der Ergebnisse. Das Gesetz der großen Zahlen beschreibt, in welcher Form die Durchschnitte der Ergebnisse bei wachsender Anzahl der Experimente gegen den endlichen Erwartungswert streben, oder anders gesagt, wie die Stichprobenmittelwerte bei wachsendem Stichprobenumfang gegen den Erwartungswert konvergieren.

Ein endlicher Erwartungswert bestimmt die Lokalisation (Lage) der Verteilung der Zufallsvariablen und ist vergleichbar mit dem empirischen arithmetischen Mittel einer Häufigkeitsverteilung in der deskriptiven Statistik, jedoch mit einem wichtigen Unterschied: Der Erwartungswert ist der „wahre“ Mittelwert einer Zufallsvariablen (Mittelwert der Grundgesamtheit), während sich das arithmetische Mittel in der Regel nur auf eine Stichprobe von Werten bezieht (Stichprobenmittel). Eine neue Stichprobe wird einen unterschiedlichen arithmetischen Mittelwert liefern, jedoch bleibt der Erwartungswert immer gleich.

Der Erwartungswert berechnet sich als nach der Wahrscheinlichkeit gewichtetes Mittel der Werte, die die Zufallsvariable annimmt. Er muss selbst jedoch nicht einer dieser Werte sein.

Weil der Erwartungswert einer Zufallsvariablen nur von deren Wahrscheinlichkeitsverteilung abhängt, wird auch vom Erwartungswert einer Wahrscheinlichkeitsverteilung gesprochen, ohne Bezug auf eine Zufallsvariable. Der endliche Erwartungswert einer Zufallsvariablen kann als Schwerpunkt der Wahrscheinlichkeitsmasse betrachtet werden und wird daher als ihr erstes Moment bezeichnet.

Motivation

Die Augenzahlen beim Würfelwurf können als unterschiedliche Ausprägungen einer Zufallsvariablen betrachtet werden. Weil die (tatsächlich beobachteten) relativen Häufigkeiten sich gemäß dem Gesetz der großen Zahlen mit wachsendem Stichprobenumfang den theoretischen Wahrscheinlichkeiten der einzelnen Augenzahlen annähern, muss der Mittelwert gegen den Erwartungswert von streben. Zu dessen Berechnung werden die möglichen Ausprägungen mit ihrer theoretischen Wahrscheinlichkeit gewichtet.

Wie die Ergebnisse der Würfelwürfe ist der Mittelwert vom Zufall abhängig. Im Unterschied dazu ist der Erwartungswert eine feste Kennzahl der Verteilung der Zufallsvariablen .

Die Definition des Erwartungswerts steht in Analogie zum gewichteten Mittelwert von empirisch beobachteten Zahlen. Hat zum Beispiel eine Serie von zehn Würfelversuchen die Ergebnisse 4, 2, 1, 3, 6, 3, 3, 1, 4, 5 geliefert, kann der zugehörige Mittelwert

alternativ berechnet werden, indem zunächst gleiche Werte zusammengefasst und nach ihrer relativen Häufigkeit gewichtet werden:

- .

Allgemein lässt der Mittelwert der Augenzahlen in Würfen sich wie

schreiben, worin die relative Häufigkeit der Augenzahl bezeichnet.

Begriff und Notation

Begriff

Das Konzept des Erwartungswertes geht auf Christiaan Huygens zurück. In einer Abhandlung über Glücksspiele von 1656 (Van rekeningh in spelen van geluck) beschreibt Huygens den erwarteten Gewinn eines Spiels als „het is my soo veel weerdt“ („es ist mir so viel wert“). Frans van Schooten verwendete in seiner Übersetzung von Huygens’ Text ins Lateinische den Begriff expectatio („Erwartung“). Bernoulli übernahm in seiner Ars conjectandi den von van Schooten eingeführten Begriff in der Form valor expectationis („Erwartungswert“).[1]

Notation

Das Symbol E für Erwartungswert oder Expectation wurde in der englischsprachigen Literatur erst ab dem 20. Jahrhundert eingeführt.[2] Heute wird in der englischsprachigen und deutschsprachigen mathematischen Literatur häufig die Schreibweise oder oder auch mit eckigen Klammern bzw. für den Erwartungswert der Zufallsvariable verwendet.[3][4] Gelegentlich werden auch geschweifte Klammern verwendet.[5]

In der russischsprachigen Literatur findet sich die Bezeichnung .[6]

Gelegentlich werden auch die Klammern um die Zufallsvariable weggelassen, was der Schreibweise für Operatoren entspricht: oder .[7] Mit der auch vorkommenden Notation besteht hierbei nicht die Gefahr, dass der Operator mit einer Zufallsvariable verwechselt wird. Die Notation mit den eckigen Klammern hebt speziell die Tatsache hervor, dass es sich hier um ein Funktional handelt.

Die Bezeichnung des Erwartungswerts der Zufallsvariable betont die Eigenschaft als nicht vom Zufall abhängiges erstes Moment. In der Physik findet die Bra-Ket-Notation Verwendung.[2] Insbesondere wird statt für den Erwartungswert einer Größe geschrieben.

Definitionen

Ist eine Zufallsvariable diskret oder besitzt sie eine Dichte, so existieren die folgenden Formeln für den Erwartungswert.

Erwartungswert einer diskreten reellen Zufallsvariable

Im reellen diskreten Fall errechnet sich der Erwartungswert als die Summe der Produkte aus den Wahrscheinlichkeiten jedes möglichen Ergebnisses des Experiments und den „Werten“ dieser Ergebnisse.

Ist eine reelle diskrete Zufallsvariable, die die Werte mit den jeweiligen Wahrscheinlichkeiten annimmt (mit als abzählbarer Indexmenge), so errechnet sich der Erwartungswert im Falle der Existenz mit:

Es ist zu beachten, dass dabei nichts über die Reihenfolge der Summation ausgesagt wird (siehe summierbare Familie).

Ist , so besitzt genau dann einen endlichen Erwartungswert , wenn die Konvergenzbedingung

- erfüllt ist, d. h. die Reihe für den Erwartungswert absolut konvergent ist.

Für nichtnegative ganzzahlige Zufallsvariablen ist oft die folgende Eigenschaft hilfreich[8]

Diese Eigenschaft wird im Abschnitt über den Erwartungswert einer nicht-negativen Zufallsvariablen bewiesen.

Erwartungswert einer reellen Zufallsvariable mit Dichtefunktion

Hat eine reelle Zufallsvariable eine Wahrscheinlichkeitsdichtefunktion , das heißt hat das Bildmaß die Dichte bezüglich des Lebesgue-Maßes , so berechnet sich der Erwartungswert im Falle der Existenz als

- (1)

In vielen Anwendungsfällen liegt (im Allgemeinen uneigentliche) Riemann-Integrierbarkeit vor und es gilt:

- (2)

Gleichwertig zu dieser Gleichung ist, wenn Verteilungsfunktion von ist:

- (3)

(2) und (3) sind unter der gemeinsamen Voraussetzung ( ist Dichtefunktion und ist Verteilungsfunktion von ) äquivalent, was mit schulgemäßen Mitteln bewiesen werden kann.[9]

Für nichtnegative Zufallsvariablen folgt daraus die wichtige Beziehung zur Zuverlässigkeitsfunktion

Allgemeine Definition

Der Erwartungswert wird entsprechend als das Lebesgue-Integral bezüglich des Wahrscheinlichkeitsmaßes definiert: Ist eine bezüglich dem Maß integrierbare oder quasiintegrierbare Zufallsvariable auf einem Wahrscheinlichkeitsraum mit Werten in , wobei die Borelsche σ-Algebra über ist, so wird definiert

mit der Wahrscheinlichkeitsverteilung . Die Zufallsvariable besitzt genau dann einen Erwartungswert, wenn sie quasiintegrierbar ist, also die Integrale

- und

nicht beide unendlich sind, wobei und den Positiv- sowie den Negativteil von bezeichnen. In diesem Fall kann oder gelten.

Der Erwartungswert ist genau dann endlich, wenn integrierbar ist, also die obigen Integrale über und beide endlich sind. Dies ist äquivalent mit

In diesem Fall schreiben viele Autoren, der Erwartungswert existiere oder sei eine Zufallsvariable mit existierendem Erwartungswert, und schließen damit den Fall bzw. aus.

Der (endliche) Erwartungswert einer reellen Zufallsvariablen kann aber auch am Graphen ihrer Verteilungsfunktion durch eine naheliegende Flächengleichheit festgelegt werden. Es ist nämlich mit einer reellen Zahl genau dann, wenn in der --Ebene die beiden Flächen, beschrieben durch

- bzw.

denselben endlichen Flächeninhalt haben, d. h. wenn

gilt und beide uneigentlichen Riemann-Integrale konvergieren. Dazu äquivalent ist die allgemeingültige Darstellung (3), ebenfalls mit konvergenten Integralen.[10]

Elementare Eigenschaften

Linearität

Der Erwartungswert ist linear für Zufallsvariablen mit endlichem Erwartungswert. Es gilt also für beliebige, nicht notwendigerweise stochastisch unabhängige, Zufallsvariablen mit endlichen Erwartungswerten, dass

ist. Als Spezialfälle ergeben sich

- ,

und

- .

Die Linearität lässt sich auch auf endliche Summen erweitern:

Die Linearität des Erwartungswertes für Zufallsvariablen mit endlichem Erwartungswert folgt aus der Linearität des Integrals für integrierbare Funktionen. Die Voraussetzung endlicher Erwartungswerte ist wesentlich für die Anwendung der Linearitätseigenschaft als Rechenregel. Beispielsweise ist es möglich, dass und und der Erwartungswert von nicht definiert ist oder in anderen Fällen endlich ist.

Monotonie

Existieren die Erwartungswerte und , so gilt

- .

Die Voraussetzung , d. h. für alle , lässt sich abschwächen zu , d. h. fast sicher.

Wahrscheinlichkeiten als Erwartungswerte

Wahrscheinlichkeiten von Ereignissen lassen sich auch über den Erwartungswert ausdrücken. Für jedes Ereignis gilt

- ,

wobei die Indikatorfunktion von ist.

Dieser Zusammenhang ist oft nützlich, etwa zum Beweis der Tschebyschow-Ungleichung.

Dreiecksungleichung

Es gilt

und

- .

Beispiele

Würfeln

Das Experiment sei ein Würfelwurf. Als Zufallsvariable betrachten wir die gewürfelte Augenzahl, wobei jede der Zahlen 1 bis 6 mit einer Wahrscheinlichkeit von jeweils 1/6 gewürfelt wird.

Wenn beispielsweise 1000-mal gewürfelt wird, man also das Zufallsexperiment 1000-mal wiederholt und die geworfenen Augenzahlen zusammenzählt und durch 1000 dividiert, ergibt sich mit hoher Wahrscheinlichkeit ein Wert in der Nähe von 3,5. Es ist jedoch unmöglich, diesen Wert mit einem einzigen Würfelwurf zu erzielen.

Sankt-Petersburg-Paradoxon

Das Sankt-Petersburg-Paradoxon beschreibt ein Glücksspiel, dessen zufälliger Gewinn einen unendlichen Erwartungswert hat. Gemäß der klassischen Entscheidungstheorie, die auf der Erwartungswertregel basiert, sollte man daher einen beliebig hohen Einsatz riskieren. Da die Wahrscheinlichkeit für einen Verlust des Einsatzes aber beträgt, erscheint diese Empfehlung nicht rational. Eine Lösung des Paradoxons stellt die Verwendung einer logarithmischen Nutzenfunktion dar.

Zufallsvariable mit Dichte

Gegeben ist die reelle Zufallsvariable mit der Dichtefunktion

wobei die Eulersche Konstante bezeichnet.

Der Erwartungswert von berechnet sich als

Allgemeine Definition

Gegeben sei der Wahrscheinlichkeitsraum mit , die Potenzmenge von und für . Der Erwartungswert der Zufallsvariablen mit und ist

Da eine diskrete Zufallsvariable ist mit und , kann der Erwartungswert alternativ auch berechnet werden als

Weitere Eigenschaften

Erwartungswert einer nicht-negativen Zufallsvariable

Falls ist und fast sicher nicht-negativ ist, so gilt gemäß dem Satz von Fubini-Tonelli (hierbei bezeichnen die eckigen Klammern die Prädikatabbildung)

Also ist

(Die letzte Gleichheit ist richtig, da für fast alle .)

Für ergibt sich der folgende bekannte Spezialfall:

Für ganzzahlige, nichtnegative Zufallsvariablen gilt also wegen

die oben genannte Formel:

Sigma-Additivität

Sind alle Zufallsvariablen fast sicher nichtnegativ, so lässt sich die endliche Additivität sogar zur -Additivität erweitern:

Erwartungswert des Produkts von n stochastisch unabhängigen Zufallsvariablen

Wenn die Zufallsvariablen stochastisch unabhängig sind und endliche Erwartungswerte besitzen (integrierbar sind), dann hat auch das Produkt einen endlichen Erwartungswert und es gilt

- .

Insbesondere gilt auch

- für .

Wenn die Zufallsvariablen stochastisch unabhängig sind und die Zufallsvariablen endliche Erwartungswerte besitzen, dann hat auch das Produkt einen endlichen Erwartungswert und es gilt

- .[11]

Die Voraussetzung endlicher Erwartungswerte ist wesentlich. Wenn beispielsweise zwei stochastisch unabhängige Zufallsvariablen und die Erwartungswerte und haben, dann ist es möglich, dass nicht definiert ist. Die Zufallsvariable besitze eine Standard-Cauchy-Verteilung, dann ist nicht definiert. Andererseits gilt mit , , wobei und stochastisch unabhängig sind mit den Erwartungswerten und .

Erwartungswert des Produkts von nicht stochastisch unabhängigen Zufallsvariablen

Falls die Zufallsvariablen und nicht stochastisch unabhängig sind, gilt für deren Produkt:

Dabei ist die Kovarianz zwischen und .

Erwartungswert einer zusammengesetzten Zufallsvariable

Ist eine zusammengesetzte Zufallsvariable, sprich sind unabhängige Zufallsvariablen und sind die identisch verteilt und ist auf definiert, so lässt sich darstellen als

- .

Existieren die ersten Momente von , so gilt

- .

Diese Aussage ist auch als Formel von Wald bekannt. Sie wird z. B. in der Schadensversicherungsmathematik benutzt.

Monotone Konvergenz

Sind die nichtnegativen Zufallsvariablen fast sicher punktweise monoton wachsend und konvergieren fast sicher gegen eine weitere Zufallsvariable , so gilt

- .

Dies ist der Satz von der monotonen Konvergenz in der wahrscheinlichkeitstheoretischen Formulierung.

Berechnung mittels der kumulantenerzeugenden Funktion

Die kumulantenerzeugende Funktion einer Zufallsvariable ist definiert als

- .

Wird sie abgeleitet und an der Stelle 0 ausgewertet, so ist der Erwartungswert:

- .

Die erste Kumulante ist also der Erwartungswert.

Berechnung mittels der charakteristischen Funktion

Die charakteristische Funktion einer Zufallsvariable ist definiert als . Mit ihrer Hilfe lässt sich durch Ableiten der Erwartungswert der Zufallsvariable bestimmen:

- .

Berechnung mittels der momenterzeugenden Funktion

Ähnlich wie die charakteristische Funktion ist die momenterzeugende Funktion definiert als

- .

Auch hier lässt sich der Erwartungswert einfach bestimmen als

- .

Dies folgt daraus, dass der Erwartungswert das erste Moment ist und die k-ten Ableitungen der momenterzeugenden Funktion an der 0 genau die k-ten Momente sind.

Berechnung mittels der wahrscheinlichkeitserzeugenden Funktion

Wenn nur natürliche Zahlen als Werte annimmt, lässt sich der Erwartungswert für auch mithilfe der wahrscheinlichkeitserzeugenden Funktion

- .

berechnen. Es gilt dann

- ,

falls der linksseitige Grenzwert existiert.

Beste Approximation

Ist eine Zufallsgröße auf einem Wahrscheinlichkeitsraum , so beschreibt die beste Approximation an im Sinne der Minimierung von , wobei a eine reelle Konstante ist. Dies folgt aus dem Satz über die beste Approximation, da

für alle konstanten ist, wobei das -Standardnormalskalarprodukt bezeichne. Diese Auffassung des Erwartungswertes macht die Definition der Varianz als minimaler mittlerer quadratischer Abstand sinnvoll, siehe auch Fréchet-Prinzip.

Erwartungswerte von Funktionen von Zufallsvariablen

Funktion einer Zufallsvariablen

sei eine stetige Zufallsvariable mit der Dichtefunktion . Wenn wieder eine Zufallsvariable ist, so kann der Erwartungswert von auf zwei Arten bestimmt werden. Entweder kann über den Zusammenhang die Wahrscheinlichkeitsverteilung von bestimmt und dann die Definition des Erwartungswertes verwendet werde, oder aber – und dies ist häufig einfacher – es wird die Formel

verwendet. Dieser Erwartungswert ist endlich, falls

endlich ist.

Bei einer diskreten Zufallsvariablen mit der Wahrscheinlichkeitsfunktion wird die Summe

verwendet. Enthält die Summe unendlich viele Summanden, dann muss die Reihe absolut konvergieren, damit der Erwartungswert endlich ist.

Im allgemeinen Fall einer Zufallsvariablen mit der Verteilungsfunktion kann der Erwartungswert mit Hilfe des Lebesgue-Stieltjes-Integral als

bestimmt werden. ist endlich, falls endlich ist. Falls mindestens einer der nichtnegativen Erwartungswerte und endlich ist, ist = , anderenfalls ist nicht definiert. Falls nicht nur endliche Erwartungswerte interessieren, müssen analoge Fallunterscheidungen auch für die Fälle einer stetigen oder diskreten Zufallsvariable vorgenommen werden, d. h. die positiven und die negativen Werte von müssen getrennt ausgewertet werden.

Funktion von zwei Zufallsvariablen mit gemeinsamer Dichtefunktion

Haben die integrierbaren Zufallsvariablen und eine gemeinsame Wahrscheinlichkeitsdichtefunktion , so kann der Erwartungswert einer Funktion von und nach dem Satz von Fubini, wenn dessen Voraussetzungen erfüllt sind, wenn also endlich ist oder wenn nichtnegativ ist, als

berechnet werden. Der Erwartungswert von ist nur dann endlich, wenn das Integral

endlich ist.

Insbesondere ist:

Aus der Randdichte errechnet sich der Erwartungswert wie bei univariaten Verteilungen:

Dabei ist die Randdichte gegeben durch

Verwandte Konzepte und Verallgemeinerungen

Lageparameter

Wird der Erwartungswert als Schwerpunkt der Verteilung einer Zufallsvariable aufgefasst, so handelt es sich um einen Lageparameter. Dieser gibt an, wo sich der Hauptteil der Verteilung befindet. Weitere Lageparameter sind

- der Modus: Der Modus gibt an, an welcher Stelle die Verteilung ein Maximum hat, sprich bei diskreten Zufallsvariablen die Ausprägung mit der größten Wahrscheinlichkeit und bei stetigen Zufallsvariable die Maximastellen der Dichtefunktion. Der Modus existiert zwar im Gegensatz zum Erwartungswert immer, muss aber nicht eindeutig sein. Beispiele für nichteindeutige Modi sind bimodale Verteilungen.

- der Median ist ein weiterer gebräuchlicher Lageparameter. Er gibt an, welcher Wert auf der x-Achse die Wahrscheinlichkeitsdichte so trennt, dass links und rechts des Medians jeweils die Hälfte der Wahrscheinlichkeit anzutreffen ist. Auch der Median existiert immer, muss aber (je nach Definition) nicht eindeutig sein.

Momente

Wird der Erwartungswert als erstes Moment aufgefasst, so ist er eng verwandt mit den Momenten höherer Ordnung. Da diese wiederum durch den Erwartungswert in Verknüpfung mit einer Funktion definiert werden, sind sie gleichsam ein Spezialfall. Einige der bekannten Momente sind:

- Die Varianz: Zentriertes zweites Moment, . Hierbei ist der Erwartungswert.

- Die Schiefe: Zentriertes drittes Moment, normiert auf die dritte Potenz der Standardabweichung . Es ist .

- Die Wölbung: Zentriertes viertes Moment, normiert auf . Es ist .

Bedingter Erwartungswert

Der bedingte Erwartungswert ist eine Verallgemeinerung des Erwartungswertes auf den Fall, dass gewisse Ausgänge des Zufallsexperiments bereits bekannt sind. Damit lassen sich bedingte Wahrscheinlichkeiten verallgemeinern und auch die bedingte Varianz definieren. Der bedingte Erwartungswert spielt eine wichtige Rolle in der Theorie der stochastischen Prozesse.

Quantenmechanischer Erwartungswert

Ist die Wellenfunktion eines Teilchens in einem bestimmten Zustand und ist ein Operator, so ist

der quantenmechanische Erwartungswert von im Zustand . ist hierbei der Ortsraum, in dem sich das Teilchen bewegt, ist die Dimension von , und ein hochgestellter Stern steht für komplexe Konjugation.

Lässt sich als formale Potenzreihe schreiben (und das ist oft so), so wird die Formel verwendet

Der Index an der Erwartungswertsklammer wird nicht nur wie hier abgekürzt, sondern manchmal auch ganz weggelassen.

- Beispiel

Der Erwartungswert des Aufenthaltsorts in Ortsdarstellung ist

Der Erwartungswert des Aufenthaltsorts in Impulsdarstellung ist

wobei wir die Wahrscheinlichkeitsdichtefunktion der Quantenmechanik im Ortsraum identifiziert haben.

Erwartungswert von Matrizen und Vektoren

Sei eine stochastische -Matrix, mit den stochastischen Variablen als Elementen, dann ist der Erwartungswert von definiert als:

- .

Falls ein -Zufallsvektor vorliegt, gilt:

- .

Siehe auch

Literatur

- Krishna B. Athreya, Soumendra N. Lahiri: Measure Theory and Probability Theory (= Springer Texts in Statistics). Springer, New York NY u. a. 2006, ISBN 0-387-32903-X (MR2247694).

- Heinz Bauer: Wahrscheinlichkeitstheorie (= De Gruyter Lehrbuch). 5., durchgesehene und verbesserte Auflage. de Gruyter, Berlin u. a. 2002, ISBN 3-11-017236-4 (MR1902050).

- Kai Lai Chung: A Course in Probability Theory. 3. Auflage. Academic Press, San Diego CA u. a. 2001, ISBN 0-12-174151-6 (R1796326).

- Walter Greiner: Quantenmechanik. 6. überarbeitete und erweiterte Auflage. Deutsch, Frankfurt am Main 2005, ISBN 3-8171-1765-5.

- Erich Härtter: Wahrscheinlichkeitsrechnung für Wirtschafts- und Naturwissenschaftler (= Uni-Taschenbücher. Nr. 409). Vandenhoeck & Ruprecht, Göttingen 1974, ISBN 3-525-03114-9.

- Norbert Henze: Stochastik für Einsteiger. Eine Einführung in die faszinierende Welt des Zufalls. 10., überarbeitete Auflage. Springer Spektrum, Wiesbaden 2013, ISBN 978-3-658-03076-6.

- Achim Klenke: Wahrscheinlichkeitstheorie. 3., überarbeitete und ergänzte Auflage. Springer Spektrum, Berlin u. a. 2013, ISBN 978-3-642-36017-6.

- Norbert Kusolitsch: Maß- und Wahrscheinlichkeitstheorie. Eine Einführung (= Springer-Lehrbuch). 2., überarbeitete und erweiterte Auflage. Springer Spektrum, Heidelberg u. a. 2014, ISBN 978-3-642-45386-1.

- Michel Loève: Probability Theory I (= Graduate Texts in Mathematics. Band 45). 4. Auflage. Springer Verlag, New York NY u. a. 1977, ISBN 3-540-90210-4 (MR0651017).

- Vladimir Spokoiny, Thorsten Dickhaus: Basics of Modern Mathematical Statistics (= Springer Texts in Statistics). Springer, Heidelberg u. a. 2015, ISBN 978-3-642-39908-4 (MR3289985).

Einzelnachweise

- ↑ Norbert Henze: Stochastik für Einsteiger. Eine Einführung in die faszinierende Welt des Zufalls. 7., überarbeitete und erweiterte Auflage. Vieweg + Teubner, Wiesbaden 2008, ISBN 978-3-8348-0423-5, S. 79.

- ↑ a b John Aldrich: Earliest Uses of Symbols in Probability and Statistics. 2014, (online).

- ↑ Baden-Württembergische Lehrerinnen verwenden die Schreibweise .

- ↑ David Meintrup, Stefan Schäffler: Stochastik. Theorie und Anwendungen. Springer, Berlin u. a. 2005, ISBN 3-540-21676-6.

- ↑ Eugen-Georg Woschni: Informationstechnik. Signal, System, Information. 2., bearbeitete Auflage. Verlag Technik, Berlin 1981.

- ↑ Siehe etwa (in deutscher Übersetzung) Albert N. Širjaev: Wahrscheinlichkeit (= Hochschulbücher für Mathematik. 91). Deutscher Verlag der Wissenschaften, Berlin 1988, ISBN 3-326-00195-9, S. 52 ff.

- ↑ Siehe Ilja N. Bronstein, Konstantin A. Semendjajew: Taschenbuch der Mathematik. 23. Auflage. Deutsch, Thun u. a. 1987, ISBN 3-87144-492-8. Der Operator wird hier kursiv gesetzt.

- ↑ Sheldon M. Ross: Introduction to probability models. 9. Auflage. Academic Press, Amsterdam u. a. 2007, ISBN 978-0-12-598062-3, S. 143.

- ↑ Helmut Wirths: Der Erwartungswert. Skizzen zur Begriffsentwicklung von Klasse 8 bis 13. In: Mathematik in der Schule. Band 33, Heft 6, 1995, S. 330–343.

- ↑ Roland Uhl: Charakterisierung des Erwartungswertes am Graphen der Verteilungsfunktion. Technische Hochschule Brandenburg, 2023, doi:10.25933/opus4-2986 (PDF). S. 2–4.

- ↑ Galen R. Shorack: Probability for Statisticians (= Springer Texts in Statistics). 2. Auflage. Springer, Cham 2017, ISBN 978-3-319-52206-7, S. 128, Theorem 1.1, doi:10.1007/978-3-319-52207-4.

![{\displaystyle \operatorname {E} \left[X\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2c7c7e2b2e9678ed25445dcedd76f63605d08107)

![{\displaystyle \mathbb {E} \left[X\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0da88481bc3637feba360a17031ef10deed2c4f2)

![{\displaystyle {\begin{aligned}\operatorname {E} (X)&=\int _{-\infty }^{\infty }xf(x)\,\mathrm {d} x=\int _{-\infty }^{3}x\cdot 0\,\mathrm {d} x+\int _{3}^{3\mathrm {e} }x\cdot {\frac {1}{x}}\,\mathrm {d} x+\int _{3\mathrm {e} }^{\infty }x\cdot 0\,\mathrm {d} x\\&=0+\int _{3}^{3\mathrm {e} }1\,\mathrm {d} x+0=[x]_{3}^{3\mathrm {e} }=3\mathrm {e} -3=3(\mathrm {e} -1).\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/90e78ff16b7f7cba0d4b5963e2be75a268f98bad)

![{\displaystyle \operatorname {E} (X^{p})=\int _{\Omega }X(\omega )^{p}\,\mathrm {d} P(\omega )=\int _{\Omega }\int _{0}^{\infty }px^{p-1}[x\leq X(\omega )]\,\mathrm {d} x\,\mathrm {d} P(\omega )=\int _{0}^{\infty }\int _{\Omega }px^{p-1}[x\leq X(\omega )]\,\mathrm {d} P(\omega )\,\mathrm {d} x=p\int _{0}^{\infty }x^{p-1}P{\big (}\{\omega \in \Omega \mid x\leq X(\omega )\}{\big )}\,\mathrm {d} x}](https://wikimedia.org/api/rest_v1/media/math/render/svg/20983c220e287a56e89b8e7dbb2a57af8d57fece)

![{\displaystyle \operatorname {E} \left[X\right]=\lim _{t\uparrow 1}m_{X}'(t)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/abf6eda3ba4f4d1c360c1ec6c97a8cfce55d4194)